兼职python爬虫要学啥?实战项目和兼职平台怎么找靠谱?

本文专为想从事Python爬虫兼职的你,系统梳理了从入门到接单的全流程。深入解析爬虫兼职需要掌握的核心技术栈,分享多个可上手的实战项目案例,并教你如何甄别靠谱的python爬虫兼职平台,规避风险。助你构建技能,开启副业之路,实现技能变现。

在数字经济的浪潮下,Python爬虫因其高效的数据获取能力,成为了许多人眼中理想的兼职技能。它似乎门槛不高,几行代码就能抓取网页信息,但真正想将此转化为稳定、可靠的兼职收入,你需要一个清晰的路线图。这不仅仅是学习几个库那么简单,而是要构建一个包含技术、项目、渠道和风险意识的完整知识体系。许多初学者兴冲冲地入门,却在“学什么、做什么、去哪做”的连环问中迷失方向,甚至遭遇骗局。本文将为你彻底剖析这三个核心问题,提供一份真正可落地的兼职爬虫进阶指南。

首先,我们必须正视一个核心问题:爬虫兼职需要掌握哪些技术? 这绝不是“会Python就行”这么轻描淡写。一个合格的兼职爬虫工程师,其技术栈应该是一个金字塔结构。塔基是扎实的Python基础,这包括但不限于熟练的数据类型操作、函数式编程、面向对象思想以及多线程/多进程基础。没有这个基础,后续的学习将举步维艰。塔身是爬虫领域的核心工具链。requests库是你与服务器沟通的桥梁,你必须精通它的各种用法,从GET、POST请求到会话维持、Cookie处理、代理设置,每一个细节都决定了你能否成功“敲门”。而BeautifulSoup4和lxml则是你解析HTML/XML的利器,你需要像外科医生一样精准地提取所需数据,理解选择器、XPath的精髓。然而,这仅仅是静态世界的通行证。现代网站大量使用JavaScript动态加载数据,这时,真正的分水岭出现了。你需要掌握Selenium或Playwright这类自动化测试工具,它们能模拟真实浏览器行为,执行JavaScript,抓取渲染后的数据。更进一步,你需要学会使用浏览器开发者工具(F12)分析网络请求,直接找到隐藏的API接口,这往往比模拟点击更高效、更稳定。对于大规模、持续性的爬取任务,Scrapy框架是绕不开的里程碑。理解其异步处理、中间件、管道等核心概念,能让你从“作坊式”的脚本编写,跃升至“工业化”的数据采集。最后,塔尖是数据存储与反爬策略。你需要至少掌握一种数据库,如轻量级的SQLite或更通用的MySQL,以及非关系型数据库MongoDB,来妥善保管你的战利品。同时,你必须理解常见的反爬机制,如IP限制、User-Agent检测、验证码、动态令牌等,并掌握相应的应对策略,比如构建IP代理池、使用fake-useragent库、接入打码平台等。这才是兼职市场真正需要的技术深度。

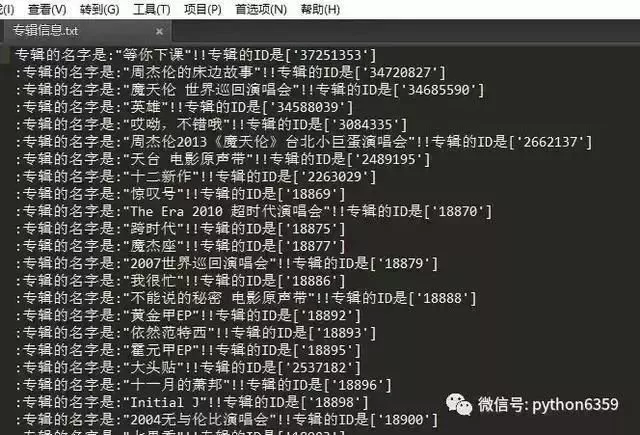

掌握了技术,下一步就是如何将其转化为一份有说服力的履历。一个空谈理论的简历远不如一个扎实的python爬虫实战项目案例。项目是你技术能力的最佳证明,也是你与需求方沟通的共同语言。那么,如何构建自己的项目库呢?建议从简单到复杂,分层递进。第一个项目,可以选择一个没有反爬的静态网站,比如某个图书排行榜、电影信息网站。目标是将书名、作者、评分、简介等信息完整地爬取下来,并存储到CSV文件或SQLite数据库中。这个项目旨在检验你对requests和BeautifulSoup的掌握程度。第二个项目,可以挑战一个动态加载的网站,比如某个社交媒体的评论区,或者电商网站的“加载更多”商品列表。你需要使用Selenium或分析API接口来完成数据抓取。这个项目能体现你应对现代Web架构的能力。第三个项目,是使用Scrapy框架,对前一个项目进行重构。你需要定义Item,编写Spider,配置Pipeline将数据存入MySQL,并尝试编写一个下载器中间件来随机更换User-Agent和代理IP。这个项目将全面展示你的工程化能力。除了这些“标准”项目,你还可以做一些创意性的小工具,比如监控某个商品价格变化并发送邮件提醒的脚本,或者爬取特定招聘网站的职位信息并进行简单的数据分析。将这些项目整理好,附上清晰的README.md文档,说明项目背景、技术实现、运行方法和最终成果,上传到你的GitHub。一个活跃且内容丰富的GitHub主页,是你寻找靠谱兼职时最有力的敲门砖。

当你的技术利剑和项目盾牌都已准备妥当,就该踏上寻找靠谱的python爬虫兼职平台的征途了。渠道的选择直接决定了你工作的质量和报酬的水平。国内主流的综合性兼职平台,如猪八戒、一品威客等,需求量大,但竞争激烈,且充斥着大量低价、甚至不靠谱的需求,需要仔细甄别。更推荐的是专注于技术领域的平台,例如程序员客栈、开源众包、CSDN外包等,这些平台的需求更专业,客户的付费意愿和认可度也相对更高。此外,不要忽视垂直社区的力量。V2EX、GitHub、各类技术论坛和QQ/微信群,经常会有一些小而美的兼职需求发布,虽然数量不多,但往往质量很高,且沟通直接。在这些渠道寻找机会时,保持专业形象至关重要。你的个人简介、项目介绍、沟通方式,都应体现出你的专业素养。面对需求时,不要急于报价,先深入理解对方的真实意图,评估技术难点和工作量,再给出一个合理的报价和工期。

然而,机遇与风险并存。在踏入兼职市场之前,你必须学会如何避免爬虫兼职骗局。这是保护自己劳动成果的最后一道,也是最重要的一道防线。凡是要求你先缴纳任何形式的“保证金”、“培训费”、“会员费”的,无一例外都是骗子,应立刻拉黑。对于那些需求描述模糊不清,比如“爬取全网XX数据”、“简单爬虫任务,报酬丰厚”的,要保持高度警惕,这背后往往是陷阱,或是想白嫖你的技术。最危险的是,有些雇主会在项目开始前就以“测试能力”为名,索要你的核心代码或完整脚本。记住,能力测试可以通过小范围、非核心的演示来完成,绝不可以在未收到任何款项的情况下交付完整源码。最安全的交易方式是通过平台进行,利用平台的托管服务,即雇主先付款到平台,你完成项目并交付,雇主确认后,平台再将款项给你。如果是私下交易,务必签订一份简单的电子合同,明确项目需求、交付标准、总金额、分阶段支付节点(如预付30%,中期30%,验收后40%)。这不仅是约束对方,更是保护自己的法律依据。记住,一个专业的工程师,首先要懂得保护自己的价值。

将Python爬虫作为一项兼职,本质上是一场将技术智慧转化为实际价值的商业实践。它要求你不仅是一个埋头写代码的程序员,更要是一个懂得分析需求、管理项目、沟通协作和规避风险的微型创业者。这条路没有捷径,每一步都需要你用代码和思考去丈量。从夯实技术基础,到打磨项目作品,再到谨慎地选择平台和客户,这是一个环环相扣的链条。当你能熟练地驾驭这个链条,你收获的将不仅仅是额外的收入,更是技术视野的拓宽、解决问题能力的提升,以及一份将知识变现的自信与从容。这趟旅程的终点,不是某个具体的兼职项目,而是一个更强大的、更具市场竞争力的自己。